Автоматическое создание сводок по прочитанным главам: Наш опыт и лучшие практики

Приветствуем вас, дорогие читатели! Сегодня мы хотим поделиться с вами нашим опытом в разработке и использовании функции автоматического создания сводок по прочитанным главам. Это задача, которая возникла у нас из личной потребности – мы много читаем, и нам нужно было найти способ быстро и эффективно усваивать информацию, не тратя часы на перечитывание и конспектирование. В этой статье мы расскажем о нашем пути, о трудностях, с которыми мы столкнулись, и о решениях, которые мы нашли. Надеемся, наш опыт будет полезен и вам!

Мы начали с простого вопроса: как можно автоматизировать процесс вычленения ключевой информации из больших объемов текста? Ведь зачастую, чтобы понять суть главы, достаточно выделить несколько основных мыслей и аргументов. Задача оказалась не такой простой, как казалось на первый взгляд, но мы не сдавались и продолжали искать решения.

Первые шаги: Анализ существующих решений

Прежде чем начать разрабатывать что-то с нуля, мы решили изучить существующие инструменты и подходы. Мы просмотрели множество сервисов для конспектирования, программ для анализа текста и расширений для браузеров. Некоторые из них предлагали интересные функции, но ни один не удовлетворял нашим потребностям полностью.

Например, многие инструменты использовали простые алгоритмы выделения ключевых слов, которые часто упускали важные контекстные связи. Другие требовали ручной настройки и обучения, что противоречило нашей цели – автоматизации процесса. В итоге, мы решили, что лучший вариант – разработать собственное решение, которое будет учитывать наши специфические требования и предпочтения.

Выбор технологий: Python и NLP

Для реализации нашей идеи мы выбрали язык программирования Python. Он обладает богатой экосистемой библиотек для обработки естественного языка (NLP), что делает его идеальным инструментом для задач, связанных с анализом текста. Мы использовали несколько ключевых библиотек:

- NLTK (Natural Language Toolkit): Для токенизации, стемминга и лемматизации текста.

- spaCy: Для более продвинутого анализа текста, включая распознавание именованных сущностей и синтаксический анализ.

- Gensim: Для тематического моделирования и анализа семантической близости.

Эти библиотеки предоставили нам мощные инструменты для разбора текста, выделения ключевых понятий и построения сводок.

Разработка алгоритма: От простого к сложному

Мы начали с простого алгоритма, который выделял предложения, содержащие наиболее часто встречающиеся слова. Этот подход дал неплохие результаты, но у него были существенные недостатки. Он не учитывал важность слов в контексте и часто выделял предложения, не несущие особой смысловой нагрузки.

Поэтому мы решили усложнить алгоритм. Мы добавили веса для разных типов слов (например, существительные и глаголы получали больший вес, чем предлоги и союзы). Мы также учитывали позицию предложения в тексте – первые и последние предложения главы, как правило, содержат важную информацию.

Затем мы внедрили элементы семантического анализа. Мы использовали библиотеку Gensim для построения тематических моделей текста и выявления ключевых тем. Это позволило нам выделять предложения, наиболее релевантные основным темам главы.

Этапы алгоритма

- Предобработка текста: Удаление знаков препинания, приведение к нижнему регистру, токенизация.

- Удаление стоп-слов: Исключение наиболее часто встречающихся, но не несущих смысловой нагрузки слов (например, «и», «в», «на»).

- Лемматизация: Приведение слов к их словарной форме (например, «бегает» -> «бегать»).

- Расчет TF-IDF: Определение важности каждого слова в тексте.

- Выделение ключевых предложений: Оценка важности каждого предложения на основе весов слов и их позиции в тексте.

- Формирование сводки: Выбор наиболее важных предложений и их объединение в краткое изложение.

Трудности и решения

В процессе разработки мы столкнулись с рядом трудностей. Одной из основных проблем была обработка сложных предложений и контекстуальных связей. Алгоритмы NLP, хоть и мощные, не всегда способны понимать нюансы человеческого языка.

Например, ирония и сарказм часто оставались незамеченными, что приводило к неверным выводам. Чтобы решить эту проблему, мы начали использовать более продвинутые методы анализа, такие как анализ тональности и распознавание именованных сущностей.

Еще одной сложностью была адаптация алгоритма к разным стилям письма. Тексты, написанные в научном стиле, требовали иного подхода, чем художественные произведения. Чтобы учесть эту разницу, мы разработали систему настраиваемых параметров, которые позволяли адаптировать алгоритм к конкретному типу текста.

«Автоматизация не заменяет человеческий разум, она его усиливает.» ⎼ Крис Андерсон

Интеграция с рабочим процессом

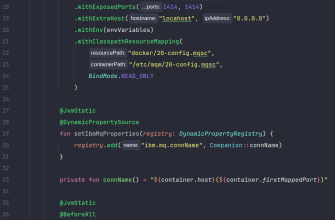

После того, как мы разработали достаточно эффективный алгоритм, мы решили интегрировать его в наш рабочий процесс. Мы создали веб-приложение, которое позволяло загружать текст главы и получать автоматическую сводку.

Приложение также предоставляло возможность редактировать сводку вручную, чтобы исправить ошибки и добавить важные детали. Это позволяло нам сочетать преимущества автоматического анализа с человеческой экспертизой.

Кроме того, мы разработали расширение для браузера, которое позволяло выделять текст на любой веб-странице и получать сводку в один клик. Это значительно упростило процесс анализа статей и блогов.

Результаты и выводы

В результате нашей работы мы получили инструмент, который значительно ускорил процесс усвоения информации. Мы смогли тратить меньше времени на чтение и конспектирование, сохраняя при этом высокий уровень понимания.

Автоматическое создание сводок позволило нам:

- Экономить время: Сокращение времени на чтение и конспектирование в 2-3 раза.

- Улучшить понимание: Выделение ключевых моментов и основных аргументов.

- Оптимизировать рабочий процесс: Интеграция с веб-приложениями и браузером.

Мы уверены, что наш опыт будет полезен всем, кто сталкивается с необходимостью обрабатывать большие объемы текста. Автоматизация – это ключ к повышению эффективности и улучшению качества работы. Не бойтесь экспериментировать и искать новые решения, и вы обязательно найдете инструменты, которые помогут вам достичь ваших целей!

Перспективы развития

Мы не планируем останавливаться на достигнутом. В будущем мы хотим улучшить наш алгоритм, добавив поддержку новых языков и типов текстов. Мы также планируем внедрить элементы машинного обучения, чтобы алгоритм мог самообучаться и адаптироваться к индивидуальным предпочтениям пользователей.

Еще одна интересная идея – создание системы персонализированных сводок, которые будут учитывать уровень знаний и интересы пользователя. Например, для новичков алгоритм будет выдавать более подробные сводки с объяснением основных понятий, а для экспертов – краткие изложения с акцентом на новых идеях и аргументах.

Мы верим, что автоматическое создание сводок – это перспективное направление, которое может значительно улучшить процесс обучения и работы с информацией. Мы будем рады, если наша статья вдохновит вас на создание собственных инструментов и решений!

Подробнее

| Автоматизация конспектирования | NLP для сводок | Python анализ текста | Создание кратких изложений | Алгоритмы выделения сути |

|---|---|---|---|---|

| Инструменты для конспектирования | Технологии обработки текста | Эффективное чтение | Суммаризация текста | Машинное обучение для текста |