- Web Scraping: Создаем Автоматическое Обновление Информации

- Что такое Web Scraping?

- Необходимые Инструменты и Технологии

- Пошаговая Инструкция по Созданию Скрейпера

- Советы по работе с динамическим контентом

- Обработка Ошибок и Ограничений

- Хранение и Обработка Собранных Данных

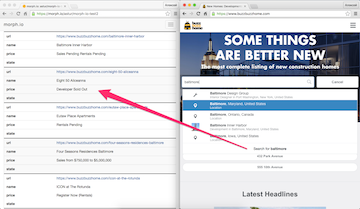

- Примеры Практического Применения Web Scraping

- Юридические и Этические Аспекты Web Scraping

- Автоматизация Обновления Информации

Web Scraping: Создаем Автоматическое Обновление Информации

В современном мире информация – это ключ к успеху. Иногда нам необходимо отслеживать изменения на веб-сайтах: цены на товары, новости, данные о погоде. Вручную проверять все эти источники – занятие утомительное и неэффективное. К счастью, существует технология web scraping, позволяющая автоматизировать этот процесс. Вместе мы разберемся, как создать функцию автоматического обновления информации, которая сэкономит наше время и усилия.

Что такое Web Scraping?

Существует множество применений web scraping. Например, мы можем отслеживать цены на товары в интернет-магазинах, собирать информацию о вакансиях на сайтах по трудоустройству, анализировать отзывы о продуктах и услугах, или даже получать данные о спортивных результатах в реальном времени. Возможности практически безграничны, и все зависит от наших потребностей и фантазии.

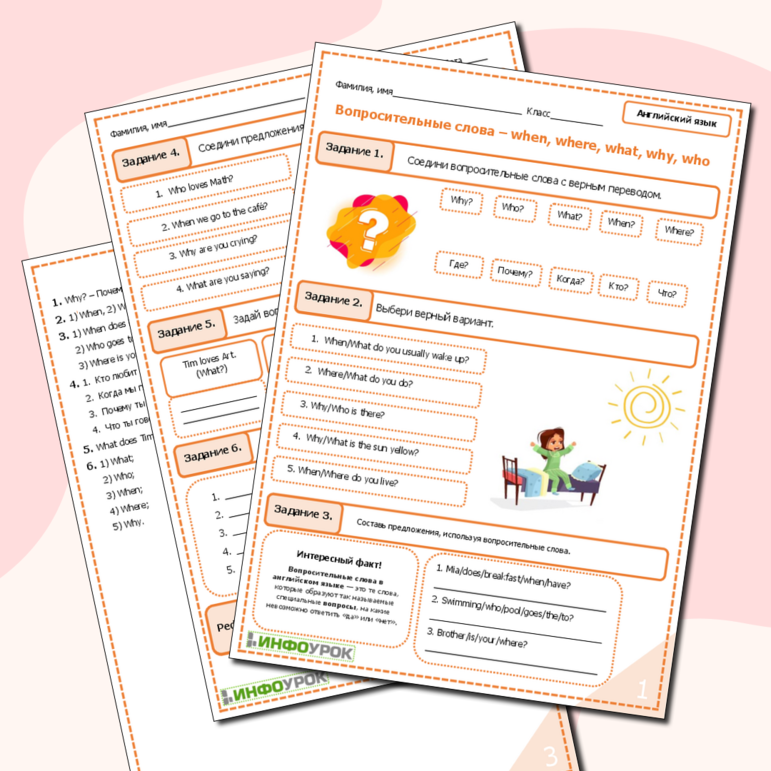

Необходимые Инструменты и Технологии

Для успешного web scraping нам потребуется несколько ключевых инструментов и технологий. Вот основные из них:

- Язык программирования: Python – один из самых популярных языков для web scraping благодаря своей простоте, гибкости и наличию большого количества библиотек.

- Библиотеки для парсинга HTML:

Beautiful Soup– помогает разбирать HTML-код и извлекать нужные данные с помощью CSS-селекторов или XPath. Также можно использоватьlxmlдля более быстрой обработки больших объемов данных.

Кроме того, нам может понадобиться библиотека Selenium для работы с динамическими веб-страницами, которые используют JavaScript для загрузки контента. Selenium позволяет автоматизировать действия браузера, такие как нажатие кнопок, заполнение форм и прокрутка страниц.

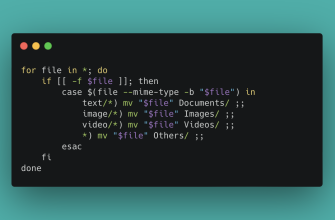

Пошаговая Инструкция по Созданию Скрейпера

Теперь давайте перейдем к практической части и создадим простой скрейпер, который будет извлекать заголовки статей с новостного сайта. Мы будем использовать Python, requests и Beautiful Soup.

- Установка необходимых библиотек: Откройте терминал или командную строку и выполните следующие команды:

- Запуск скрипта: Сохраните скрипт в файл с расширением

.pyи запустите его из терминала:

pip install requests beautifulsoup4

import requests

url = 'https://www.example.com/news' # Замените на URL новостного сайта

response = requests.get(url)

from bs4 import BeautifulSoup

headlines = soup.find_all('h2', class_='headline') # Замените 'h2' и 'headline' на соответствующие значения

for headline in headlines:

print(headline.text)

python your_script_name.pyЭтот пример демонстрирует базовый процесс web scraping. В зависимости от сложности сайта и требуемых данных, вам может потребоваться более сложный код и дополнительные библиотеки.

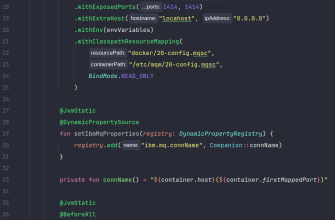

Советы по работе с динамическим контентом

Многие современные веб-сайты используют JavaScript для динамической загрузки контента. В таких случаях, библиотеки requests и Beautiful Soup могут оказаться недостаточными, так как они не могут выполнить JavaScript-код. Для работы с динамическим контентом нам потребуется использовать Selenium.

- Установка Selenium и WebDriver: Установите

Seleniumс помощью pip: - Также необходимо скачать WebDriver для вашего браузера (например, ChromeDriver для Chrome или GeckoDriver для Firefox) и добавить его в системную переменную PATH.

- Автоматизация браузера с помощью Selenium: Напишите Python-скрипт, который открывает браузер, переходит на нужную страницу и извлекает данные после загрузки JavaScript-кода.

pip install selenium

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.options import Options # Или FirefoxOptions

Настройка Chrome

chrome_options = Options

chrome_options.add_argument("--headless") # Запуск в фоновом режиме

driver = webdriver.Chrome(options=chrome_options) # Или webdriver.Firefox

url = 'https://www.example.com/dynamic_page' # Замените на URL динамической страницы

driver.get(url)

Подождите, пока контент загрузится (например, 5 секунд)

driver.implicitly_wait(5)

Найдите элементы, содержащие данные

elements = driver.find_elements(By.CLASS_NAME, 'data-item') # Замените 'data-item' на соответствующий класс

for element in elements:

print(element.text)

driver.quit

Selenium позволяет нам взаимодействовать с веб-страницей так же, как это делал бы обычный пользователь, что делает его мощным инструментом для web scraping динамических сайтов.

Обработка Ошибок и Ограничений

Web scraping – не всегда простой процесс. Мы можем столкнуться с различными ошибками и ограничениями, которые необходимо учитывать.

- Блокировка IP-адреса: Веб-сайты могут блокировать IP-адреса, с которых поступает слишком много запросов. Чтобы избежать этого, необходимо соблюдать этикет web scraping:

- Использовать задержки между запросами: Добавляйте небольшие задержки (например, 1-2 секунды) между запросами, чтобы не перегружать сервер.

- Использовать User-Agent: Указывайте User-Agent в HTTP запросах, чтобы представиться браузером, а не ботом.

- Использовать прокси-серверы: Используйте прокси-серверы для изменения IP-адреса и обхода блокировок.

- Изменения в структуре сайта: Веб-сайты могут менять свою структуру, что может привести к поломке скрейпера. Необходимо регулярно проверять и обновлять код скрейпера, чтобы адаптироватся к изменениям.

- CAPTCHA: Некоторые сайты используют CAPTCHA для защиты от ботов. Решение CAPTCHA – сложная задача, но существуют сервисы, которые могут помочь автоматизировать этот процесс.

- robots.txt: Всегда проверяйте файл

robots.txtна сайте, чтобы узнать, какие страницы запрещено сканировать. Уважайте правила, установленные владельцами сайтов.

«Информация ー это валюта будущего.» ─ Alvin Toffler

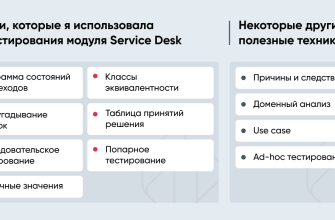

Хранение и Обработка Собранных Данных

После того как мы собрали данные с веб-сайтов, нам необходимо их сохранить и обработать. Существует несколько способов хранения данных:

- CSV-файлы: Простой и удобный формат для хранения табличных данных.

- JSON-файлы: Гибкий формат для хранения структурированных данных.

- Базы данных: MySQL, PostgreSQL, MongoDB – позволяют хранить большие объемы данных и выполнять сложные запросы;

Для обработки данных можно использовать различные инструменты и библиотеки, такие как pandas, NumPy и scikit-learn. pandas позволяет легко манипулировать табличными данными, NumPy предоставляет инструменты для выполнения математических операций, а scikit-learn – для машинного обучения.

Примеры Практического Применения Web Scraping

Web scraping может быть полезен во многих областях. Вот несколько примеров практического применения:

- Мониторинг цен: Отслеживание цен на товары в интернет-магазинах и сравнение их с ценами конкурентов.

- Анализ отзывов: Сбор и анализ отзывов о продуктах и услугах для выявления тенденций и улучшения качества.

- Сбор данных о вакансиях: Сбор информации о вакансиях с различных сайтов по трудоустройству и автоматическое создание резюме.

- Мониторинг новостей: Сбор новостей с различных источников и создание персонализированной новостной ленты.

- Исследование рынка: Сбор данных о рынке, конкурентах и потребителях для принятия обоснованных бизнес-решений.

Юридические и Этические Аспекты Web Scraping

Web scraping – это мощный инструмент, но его необходимо использовать ответственно и в соответствии с законом. Важно помнить о следующих юридических и этических аспектах:

- Условия использования сайта: Внимательно читайте условия использования сайта, чтобы убедиться, что web scraping не запрещен.

- Авторские права: Не нарушайте авторские права на контент, собранный с помощью web scraping.

- Конфиденциальность: Защищайте личную информацию пользователей, собранную с помощью web scraping.

- Этикет: Соблюдайте этикет web scraping, чтобы не перегружать серверы и не нарушать работу сайтов.

Web scraping должен быть полезным инструментом, а не средством для злоупотреблений. Всегда используйте его с уважением к владельцам сайтов и их пользователям.

Автоматизация Обновления Информации

После того, как мы создали скрейпер, нам нужно автоматизировать процесс обновления информации. Для этого можно использовать различные инструменты и технологии:

- Планировщик задач (Cron): Cron – это планировщик задач, который позволяет автоматически запускать скрипты по расписанию. Он доступен на большинстве Unix-подобных операционных систем, включая Linux и macOS.

- Облачные сервисы: AWS Lambda, Google Cloud Functions, Azure Functions – позволяют запускать скрипты в облаке без необходимости управления серверами.

- Библиотека schedule (Python): Простая и удобная библиотека для планирования задач в Python.

Выбор инструмента зависит от наших потребностей и инфраструктуры. Cron – отличный вариант для локального запуска скриптов, а облачные сервисы – для масштабируемых и надежных решений.

Подробнее

| Python web scraping | Beautiful Soup tutorial | Selenium web scraping | Web scraping ethical | Automated data extraction |

|---|---|---|---|---|

| Web scraping legal | Dynamic web scraping | Proxies for web scraping | Web scraping best practices | Data scraping tools |