Укрощение левиафана: Как эффективно работать с гигантскими словарями терминов

Работать с большими объемами данных всегда непросто, и словари терминов не исключение. Когда количество элементов переваливает за десятки, а то и сотни тысяч, привычные методы становятся неэффективными. Мы, как и многие из вас, сталкивались с этой проблемой и потратили немало времени на поиски оптимальных решений. В этой статье мы поделимся нашим опытом и расскажем, как можно оптимизировать работу с большими словарями терминов, чтобы сделать ее быстрее, удобнее и, главное, результативнее.

Проблемы при работе с большими словарями

Прежде чем переходить к решениям, давайте четко обозначим проблемы, с которыми мы сталкиваемся при работе с большими словарями терминов. Это поможет нам лучше понять, какие именно аспекты нуждаются в оптимизации;

- Медленный поиск: Поиск нужного термина в огромном списке может занимать очень много времени, особенно если не использовать правильные инструменты.

- Высокое потребление памяти: Загрузка и хранение больших словарей в памяти может быть ресурсоемкой задачей, особенно на устройствах с ограниченными ресурсами.

- Сложность обновления: Внесение изменений в большой словарь (добавление, удаление, редактирование терминов) может быть трудоемким и занимать много времени.

- Трудности в организации: Поддержание структуры и порядка в большом словаре – задача не из легких. Без правильной организации легко запутаться и потерять нужную информацию.

- Риск ошибок: Чем больше данных, тем выше вероятность ошибок. Опечатки, неточности и дубликаты могут значительно снизить качество словаря.

Выбор правильной структуры данных

Правильный выбор структуры данных – это фундамент эффективной работы с большими словарями. От этого зависит скорость поиска, потребление памяти и удобство работы с данными. Вот несколько вариантов, которые мы рассматривали:

- Хеш-таблицы (словари): Отличное решение для быстрого поиска по ключу. Идеально подходят, если вам нужно быстро находить определения терминов по их названиям.

- Деревья поиска (например, B-деревья): Обеспечивают быструю вставку, удаление и поиск элементов. Хороший выбор, если словарь часто обновляется.

- Префиксные деревья (Trie): Оптимизированы для поиска по префиксу. Полезны, если вам нужно реализовать автозаполнение или поиск терминов, начинающихся с определенной буквы.

- Базы данных (например, SQLite, PostgreSQL): Подходят для хранения очень больших словарей, которые не помещаются в памяти. Обеспечивают возможность индексирования и выполнения сложных запросов.

Выбор конкретной структуры зависит от ваших потребностей. Если вам нужен быстрый поиск и словарь редко обновляется, то хеш-таблица – отличный выбор. Если же словарь часто меняется и важна возможность поиска по префиксу, то стоит рассмотреть префиксное дерево.

Оптимизация алгоритмов поиска

Даже с правильно выбранной структурой данных алгоритм поиска может существенно влиять на производительность. Вот несколько советов по оптимизации алгоритмов поиска:

- Используйте встроенные функции поиска: Многие языки программирования и библиотеки предоставляют оптимизированные функции поиска для различных структур данных. Используйте их вместо написания собственных алгоритмов с нуля.

- Применяйте бинарный поиск: Если данные отсортированы, бинарный поиск может значительно ускорить процесс поиска.

- Кэшируйте результаты поиска: Если вы часто ищете одни и те же термины, кэширование результатов поиска может существенно повысить производительность.

- Используйте многопоточность: Если у вас многоядерный процессор, распараллеливание поиска может значительно ускорить процесс.

Сжатие данных

Сжатие данных – это эффективный способ уменьшить потребление памяти и ускорить загрузку словаря. Существует множество алгоритмов сжатия, каждый из которых имеет свои преимущества и недостатки. Вот несколько популярных вариантов:

- gzip: Универсальный алгоритм сжатия, который хорошо подходит для сжатия текстовых данных.

- bzip2: Обеспечивает более высокую степень сжатия, чем gzip, но работает медленнее.

- LZ4: Очень быстрый алгоритм сжатия, который хорошо подходит для сжатия данных в реальном времени.

- Специализированные алгоритмы: Для определенных типов данных (например, изображений или аудио) существуют специализированные алгоритмы сжатия, которые обеспечивают лучшую степень сжатия, чем универсальные алгоритмы.

Выбор алгоритма сжатия зависит от ваших требований к скорости сжатия и степени сжатия. Если важна скорость, то стоит выбрать LZ4. Если важна степень сжатия, то стоит рассмотреть bzip2.

«Информация ⎼ это не знание. Единственный источник знания ⎻ опыт.»

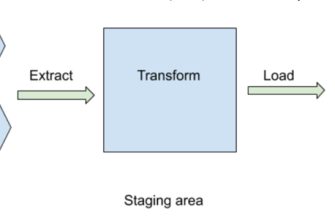

Разделение словаря на части

Если словарь настолько велик, что не помещается в памяти, его можно разделить на несколько частей и загружать только те части, которые необходимы для выполнения конкретной задачи. Это позволяет снизить потребление памяти и ускорить загрузку словаря.

Существует несколько способов разделения словаря на части:

- По алфавиту: Разделить словарь на части по первой букве термина.

- По категориям: Разделить словарь на части по категориям терминов.

- По частоте использования: Разделить словарь на части по частоте использования терминов.

Выбор способа разделения зависит от ваших потребностей. Если вы часто ищете термины, начинающиеся с определенной буквы, то разделение по алфавиту – хороший выбор. Если вы работаете с определенной категорией терминов, то разделение по категориям – более подходящий вариант.

Использование баз данных

Как мы уже упоминали, базы данных – это отличное решение для хранения очень больших словарей. Они обеспечивают возможность индексирования, выполнения сложных запросов и управления данными. Вот несколько популярных баз данных, которые можно использовать для хранения словарей терминов:

- SQLite: Легковесная база данных, которая не требует установки и хорошо подходит для небольших и средних словарей;

- PostgreSQL: Мощная и гибкая база данных, которая хорошо подходит для больших и сложных словарей.

- MySQL: Популярная база данных, которая хорошо подходит для веб-приложений.

- NoSQL базы данных (например, MongoDB, Cassandra): Подходят для хранения неструктурированных данных и работы с большими объемами данных.

Выбор базы данных зависит от ваших потребностей. Если вам нужна простая и легкая база данных, то SQLite – хороший выбор. Если вам нужна мощная и гибкая база данных, то стоит рассмотреть PostgreSQL.

Кэширование данных

Кэширование данных – это эффективный способ ускорить доступ к часто используемым данным. Кэш – это временное хранилище данных, которое находится ближе к процессору, чем основная память. При запросе данных сначала проверяется кэш. Если данные находятся в кэше, они возвращаются немедленно. Если данные отсутствуют в кэше, они загружаются из основной памяти и помещаются в кэш для последующего использования.

Существует несколько уровней кэширования:

- Кэш процессора: Самый быстрый, но и самый маленький кэш.

- Кэш оперативной памяти: Более медленный, чем кэш процессора, но и более вместительный.

- Кэш на жестком диске: Самый медленный, но и самый вместительный кэш.

Вы можете использовать различные библиотеки и инструменты для реализации кэширования в вашем приложении. Например, в Python можно использовать библиотеку `functools.lru_cache` для кэширования результатов функций.

Регулярная очистка и оптимизация

Со временем словарь может засоряться устаревшими и неактуальными терминами. Регулярная очистка и оптимизация словаря – это важная задача, которая позволяет поддерживать его актуальность и повышать производительность.

Вот несколько советов по очистке и оптимизации словаря:

- Удаляйте устаревшие термины: Регулярно проверяйте словарь на наличие устаревших терминов и удаляйте их.

- Обновляйте определения терминов: Убедитесь, что определения терминов актуальны и соответствуют текущим знаниям.

- Удаляйте дубликаты: Проверяйте словарь на наличие дубликатов и удаляйте их.

- Оптимизируйте структуру данных: Регулярно проверяйте структуру данных и оптимизируйте ее для повышения производительности.

Работа с большими словарями терминов может быть сложной задачей, но, используя правильные инструменты и методы, можно значительно оптимизировать этот процесс. Мы поделились нашим опытом и надеемся, что наши советы помогут вам укротить левиафана и сделать вашу работу со словарями более эффективной и приятной. Помните, что нет универсального решения – выбор оптимального подхода зависит от ваших конкретных потребностей и требований.

Подробнее

| Оптимизация словарей | Работа с большими данными | Эффективный поиск терминов | Структуры данных для словарей | Сжатие словарей |

|---|---|---|---|---|

| Кэширование терминов | Базы данных для словарей | Алгоритмы поиска по словарю | Обслуживание больших словарей | Управление словарями терминов |