- Как приручить NLP: Путь к оптимизации для узкоспециализированных тем

- Почему стандартные NLP-модели не всегда работают?

- Ключевые шаги оптимизации NLP для узких тем

- Сбор и подготовка специализированных данных

- Использование предварительно обученных моделей и трансферного обучения

- Тонкая настройка модели на специализированных данных

- Включение знаний экспертов и ручная аннотация

- Оценка и итеративное улучшение

- Примеры успешной оптимизации NLP в узких областях

- Инструменты и библиотеки для оптимизации NLP

Как приручить NLP: Путь к оптимизации для узкоспециализированных тем

Добро пожаловать, друзья! Сегодня мы отправимся в захватывающее путешествие по миру обработки естественного языка (NLP), но не просто так, а с прицелом на узкоспециализированные темы. Мы, как и вы, увлечены этой областью и хотим поделиться своим опытом, чтобы вы могли с легкостью ориентироваться в сложном ландшафте NLP и добиваться впечатляющих результатов. Забудьте о стандартных подходах – мы покажем, как адаптировать NLP-модели для конкретных задач, где точность и релевантность имеют первостепенное значение.

В мире, где информация множится с невероятной скоростью, умение извлекать ценные знания из огромных массивов текста становится критически важным. Однако, когда дело доходит до узкоспециализированных тем, стандартные NLP-модели часто оказываются недостаточно эффективными. Они могут не понимать специфический жаргон, терминологию или контекст, что приводит к неточным результатам и упущенным возможностям. Именно поэтому оптимизация NLP для таких тем – это не просто желательное улучшение, а необходимость для достижения успеха.

Почему стандартные NLP-модели не всегда работают?

Прежде чем мы углубимся в методы оптимизации, давайте разберемся, почему стандартные NLP-модели могут испытывать трудности с узкоспециализированными темами. Во-первых, эти модели часто обучаются на больших, но общих корпусах текстов, которые могут не содержать достаточного количества примеров из конкретной области. Это приводит к тому, что модель не «видит» и не «понимает» специфические термины и концепции.

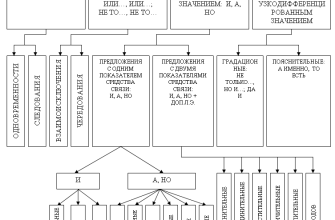

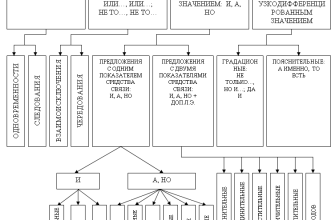

Во-вторых, даже если модель обучена на достаточном количестве данных, она может испытывать трудности с пониманием контекста. В узкоспециализированных областях слова и фразы могут иметь совершенно иное значение, чем в общем языке. Например, термин «рекурсия» в программировании имеет совершенно иное значение, чем в лингвистике. Стандартные модели, не учитывающие этот контекст, могут делать ошибочные выводы.

В-третьих, многие стандартные NLP-модели не учитывают иерархическую структуру знаний, которая часто присутствует в узкоспециализированных областях. Например, в медицине существуют четкие иерархии заболеваний, симптомов и методов лечения. Модель, не учитывающая эту иерархию, может упускать важные связи и зависимости.

Ключевые шаги оптимизации NLP для узких тем

Теперь, когда мы понимаем причины проблем, давайте перейдем к конкретным шагам, которые мы рекомендуем для оптимизации NLP-моделей для узкоспециализированных тем. Эти шаги основаны на нашем опыте и проверены на практике, поэтому мы уверены, что они помогут вам добиться значительных улучшений.

Сбор и подготовка специализированных данных

Первый и, пожалуй, самый важный шаг – это сбор и подготовка специализированных данных. Нельзя ожидать, что модель будет хорошо работать в узкой области, если она не обучена на данных из этой области. Ищите все возможные источники данных: научные статьи, книги, патенты, техническая документация, форумы, блоги и т.д. Чем больше данных вы соберете, тем лучше.

После сбора данных необходимо тщательно их подготовить. Это включает в себя очистку текста от лишних символов и форматирования, токенизацию, лемматизацию или стемминг, а также удаление стоп-слов. Особое внимание следует уделить обработке специфических терминов и сокращений. Возможно, вам потребуется создать свой собственный словарь терминов или использовать специализированные тезаурусы.

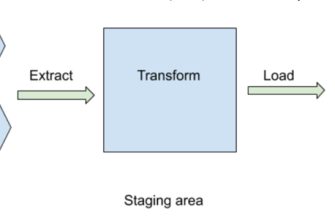

Использование предварительно обученных моделей и трансферного обучения

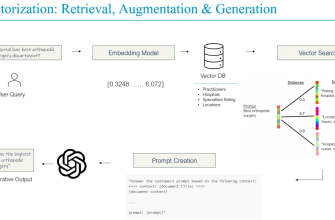

К счастью, вам не нужно начинать с нуля. Существует множество предварительно обученных NLP-моделей, которые можно адаптировать для вашей конкретной задачи. Модели, такие как BERT, RoBERTa, и GPT, обучены на огромных корпусах текстов и обладают хорошим общим пониманием языка. Используйте трансферное обучение, чтобы «перенести» знания из этих моделей в вашу узкоспециализированную область. Это значительно ускорит процесс обучения и повысит точность модели.

При выборе предварительно обученной модели обратите внимание на ее архитектуру и размер. Модели с большим количеством параметров обычно показывают лучшие результаты, но требуют больше вычислительных ресурсов и времени для обучения. Также убедитесь, что модель поддерживает язык, на котором написаны ваши данные.

Тонкая настройка модели на специализированных данных

После выбора предварительно обученной модели необходимо выполнить ее тонкую настройку на ваших специализированных данных. Это означает, что вы будете обучать модель на небольшом наборе данных, специфичном для вашей области, чтобы адаптировать ее к конкретным терминам, концепциям и контексту. Тонкая настройка позволяет модели «запомнить» специфические знания и улучшить ее производительность.

При тонкой настройке важно правильно подобрать гиперпараметры модели, такие как скорость обучения, размер батча и количество эпох. Экспериментируйте с различными значениями, чтобы найти оптимальную конфигурацию для вашей задачи. Также используйте методы регуляризации, чтобы предотвратить переобучение модели на небольшом наборе данных.

Включение знаний экспертов и ручная аннотация

В узкоспециализированных областях знания экспертов могут быть бесценными. Привлекайте экспертов для ручной аннотации данных, чтобы создать размеченный набор данных, который можно использовать для обучения и оценки модели. Эксперты могут помочь вам определить важные термины, классифицировать тексты и выявить связи между различными концепциями.

Ручная аннотация – это трудоемкий процесс, но он может значительно повысить точность и надежность вашей NLP-модели. Кроме того, ручная аннотация позволяет выявить ошибки и неточности в данных, которые могут быть пропущены автоматическими методами.

Оценка и итеративное улучшение

После обучения модели необходимо тщательно оценить ее производительность. Используйте различные метрики, такие как точность, полнота, F1-мера и AUC, чтобы оценить, насколько хорошо модель справляется с вашей задачей. Важно не только оценить общую производительность модели, но и проанализировать ее ошибки. Какие типы ошибок она делает чаще всего? Какие термины и концепции она не понимает?

На основе результатов оценки вносите изменения в модель и данные, и повторяйте процесс обучения и оценки. Это итеративный процесс, который позволяет постепенно улучшать производительность модели и адаптировать ее к вашей конкретной задаче. Не бойтесь экспериментировать с различными подходами и параметрами, чтобы найти оптимальное решение.

«Данные говорят сами за себя, но только если вы знаете, как их слушать.» ⸺ Клайв Хамби

Примеры успешной оптимизации NLP в узких областях

Чтобы вдохновить вас и показать, что оптимизация NLP для узкоспециализированных тем – это реально, давайте рассмотрим несколько примеров успешного применения этой технологии в различных областях.

- Медицина: Разработка систем для автоматического извлечения информации из медицинских записей, что позволяет врачам быстрее находить нужную информацию и принимать более обоснованные решения.

- Финансы: Создание моделей для анализа финансовых новостей и отчетов, чтобы выявлять риски и возможности для инвестиций.

- Юриспруденция: Разработка систем для автоматического поиска и анализа юридических документов, что позволяет юристам быстрее находить прецеденты и строить свои аргументы.

- Инженерия: Создание моделей для анализа технической документации и патентов, чтобы выявлять новые технологии и возможности для инноваций.

Инструменты и библиотеки для оптимизации NLP

К счастью, существует множество инструментов и библиотек, которые могут помочь вам в процессе оптимизации NLP. Вот некоторые из наиболее популярных и полезных:

- Python: Универсальный язык программирования, который широко используется в NLP.

- NLTK: Библиотека для обработки естественного языка, предоставляющая инструменты для токенизации, стемминга, лемматизации и других задач.

- spaCy: Библиотека для продвинутой обработки естественного языка, предоставляющая быстрые и точные модели для различных задач.

- Transformers: Библиотека от Hugging Face, предоставляющая доступ к предварительно обученным моделям, таким как BERT, RoBERTa и GPT.

- TensorFlow и PyTorch: Фреймворки для машинного обучения, которые можно использовать для обучения и развертывания NLP-моделей.

Оптимизация NLP для узкоспециализированных тем – это сложная, но увлекательная задача. Она требует глубокого понимания как NLP, так и конкретной области, а также готовности экспериментировать и учиться на своих ошибках; Однако, если вы приложите усилия и будете следовать нашим рекомендациям, мы уверены, что вы сможете добиться впечатляющих результатов и создать NLP-модели, которые действительно «понимают» вашу узкоспециализированную область.

Мы надеемся, что эта статья была полезной и вдохновила вас на новые свершения в мире NLP. Помните, что нет ничего невозможного, если вы готовы учиться и адаптироваться. Удачи вам в ваших NLP-проектах!

Подробнее

| Специализированные NLP модели | Обучение NLP на узких данных | Трансферное обучение в NLP | Ручная аннотация NLP данных | Оценка NLP моделей |

|---|---|---|---|---|

| NLP для медицины | NLP для финансов | NLP для юриспруденции | NLP для инженерии | Инструменты NLP оптимизации |